ChatGPT的热度仍在持续。

作为OpenAI的联合创始人,马斯克也蹭了一次热点,级别还很高。

在阿联酋举行的世界政府峰会上,当提及 ChatGPT 的发展,他说:“对未来文明的最大威胁之一是人工智能。它既是积极的,也是消极的,有很大的,很大的希望,很大的能力。但是,”他强调,“随之而来的是比核弹还巨大的危险”。

这个观点其实是老生常谈了,最近全民都讨论过了一轮。

该不该发展人工智能?100%应该,我相信人工智能的合理利用,能让人类社会发展上一个大台阶。

但是,在发展人工智能的过程中,无视伦理问题和道德风险,也是一种不负责任。

总之是有些矛盾的,多数人都抱着想要、又不敢的心理。

人与AI的关系,就是这么复杂且深奥。

01

隐秘的角落

最先进的 AI 技术,背后还是原始的劳动。

——《时代》

就像是一场演唱会,舞台上灯光闪烁,主角搔首弄姿,粉丝欢呼呐喊,场面一片火热。

而幕后忙忙碌碌的那批人,无人关注。

人工智能行业大抵如此。

AI能如人们预期工作时,硅谷企业总喜欢说一切“好似魔法”。

实则不然。

以时下最热的ChatGPT为例,作为一个对话模型,它究竟是怎么给出答案的呢?

ChatGPT也被称作GPT-3.5,与去年公布的InstructGPT是一对姊妹模型。两者在训练方式和模型结构上完全一致,仅在采集数据的方式上有所差异。

所以,尽管ChatGPT的论文及代码细节尚未公布,但我们可以通过InstructGPT来理解ChatGPT的训练细节及模型。

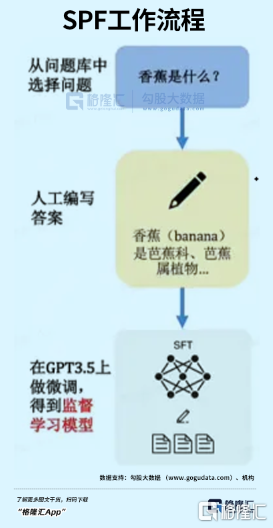

其训练步骤分为三步,分别是SFT、RM、PPO。

1. SFT

这是实现对话的第一步,全称为Supervised FindTune,本质是对数据进行优化。

GPT原本是使用互联网上海量信息库训练的模型。但互联网上鱼龙混杂,只有少部分信息是提问者需要的答案。

所以要对数据进行优化,把大众想要看到的答案,人工标注,喂给初步训练的GPT。简单来说,升级后的模型,只订阅人喜欢的内容。

基于优化后的内容,对话机器人的雏形已经生成,它可以根据问题,生成一系列答案。

缺点是不具备判断能力。比如,模型给出了A、B、C、D四个答案,用户还得判断,哪一个自己才是自己想要的。

如此麻烦,就不叫人工智能了,必须引入RM奖励模型。

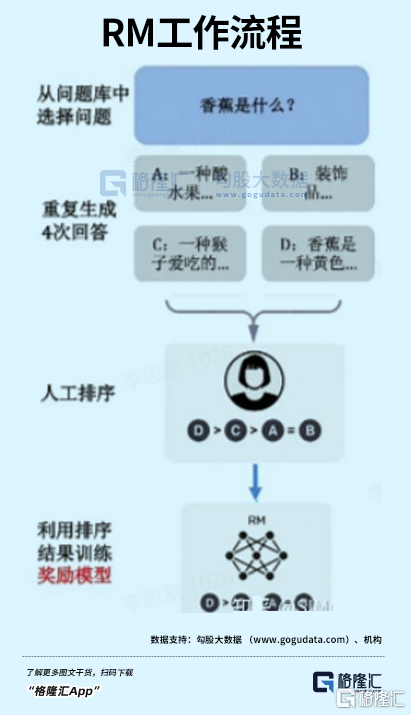

2. RM

RM技术的全称是Reinforcement Learning,它只能告诉模型生成的内容是否更好,无法教导怎么变好。

首先,如上文,初始模型根据问题生成了多个答案,人工将对给出的这些答案,进行打分和排序。

然后让AI通过人工打分的模型,记住用户更喜欢哪种类型的内容。

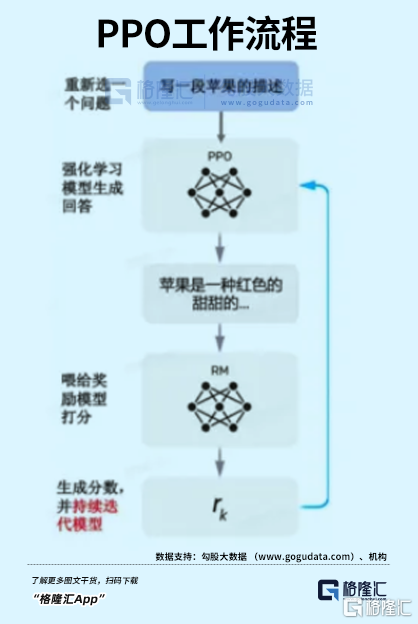

3. PPO

这一阶段,是将SFT和RM两个模型结合起来,也叫作强化学习模型。

先利用PPO的算法,微调SFT训练的生成模型,再基于RM的特性,生成一个能持续自动迭代的模型。

显而易见,第一步和第二步是根基,第三步只是用算法对内容进行整合。

而无论是第一步的“人工投喂”,还是第二步的“人工排序”,核心都在于“人”,而且是大量的人。

比如,ChatGPT的前身GPT-3,虽然能将信息组成语句,但没有经过以上三步筛选,倾向于脱口而出暴力、性别歧视和种族主义言论。

所以才无法面市。

为了搞定这个问题,OpenAI找到了Samasource,这是一家总部位于旧金山的公司,客户还包括谷歌、微软、Salesforce和雅虎等科技巨头,员工是来自肯尼亚、乌干达和印度等世界最贫穷地区的数百万穷人。

据《时代》杂志报道,OpenAI从2021年11月份开始,就向Samasource公司发送了大量的、有害的文本资料,来由人工进行label工作。

一位匿名接受了《时代》采访的肯尼亚劳工说,200个来自非洲各个国家的年轻男女坐在一间办公室里,他们每天的任务就是不停地观看埋在互联网深处最恶毒的种族歧视言论,或是令人作呕的性暴力内容、惨烈的恐怖袭击照片,在算法把这些内容大规模分发给用户前,掐灭在源头里。

这些反人类内容给观看的人造成了严重的心理创伤,很多人都宣称患上了PTSD,或展现出焦虑和抑郁的症状。

“有时候我想辞职,但紧接着我问我自己,我的孩子该怎么饱腹?”

在接受媒体采访时,Samasource声称自己是一家帮助AI变得有伦理的公司,他们向肯尼亚人提供的,是一份“有尊严的数字工作”。

但事实上,基础劳工们仅能拿到1.32- 1.44美元的时薪,“高级”点的则是每小时2美元。

相比OpenAI的290亿美元估值......

尽管对非洲和南亚的大部分人而言,每天8美元的收入已经足够维持生活,总比失业挨饿好。

乍看之下,双方的需求和兴趣似乎完美吻合,是一件双赢的事情。但这并不能改变他们创造的价值,被大幅压缩的现实。

一个很反直觉的现实是。

对Samasource而言,他们用极低的成本拿到了优化后的数据,创造了数千万美元的收益,这些收益却与其背后绝大部分真正的劳动者,几乎毫无关系。

而几乎为零的技术门槛和低廉的薪水,蒙蔽了所有劳工的双眼——他们可能没有意识到,自己经手的数据,其实是科技公司赖以生存的核心资产。

甚至在营销话术的精美包装下,他们觉得自己有幸参与到科技进步的伟大事业中。

对于任何企业而言,这样的廉价劳动力简直不能再香了,自然不可能给Samasource独享。乃至在国内,部分人力成本较低的地区,也形成了 “数据标注村”,有机构专门对接欧美 AI 公司和当地数据标注公司。

而在非洲、东南亚、南亚和拉美等地区,数据标注的廉价外包则规模庞大。

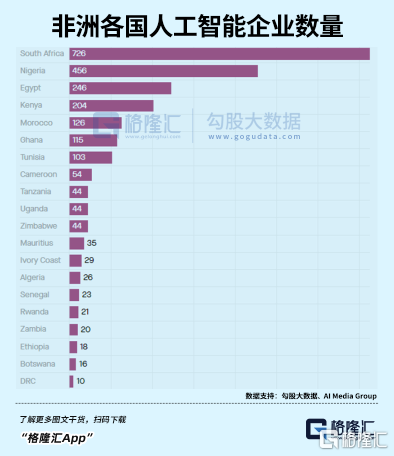

据AI Media Group发布的《2022年非洲AI现状报告》,非洲大陆有超过2400家公司将人工智能列入业务范围。

其中,40%是在五年内成立的,41%是员工不足10人的初创企业。

但众所周知,几乎所有AI专家来自北美、欧洲和东亚。其他地区,尤其是非洲,基本没有代表性的研究者。

此地唯一的优势,只是大量且廉价的劳动力。

所以这些公司到底做的是什么业务,不难想象,大抵和Samasource差不多。

就像几个世纪钱捕黑奴的“猎人”,他们大多数本身就是当地土著。

想象一下吧,就好像一个人每天的工作内容就是在大海深处最黑暗的海沟中潜行,永远也无法浮上海平面,见到阳光。

而在海平面之上,科技的大船扬帆远航,没人在意暗处的东西是什么。

ChatGPT作为一个工具,它永远也不会懂得人性和思考人性。

让AI变得更有伦理本身,已经成了一个严重的伦理问题。

不论是成长的过程,还是进入人类社会后,都是如此。

02

时间黑洞

这是智慧的时代,也是愚蠢的时代。

赛博空间正以前所未有的速度,掠夺每一个人的时间。

有机构曾统计,2000-2021年,人类注意力能维持的时间,从12秒减少到了不足8秒。

如果这是真的,也就是说,我们的大脑每8秒就会宕机一次,就像一条小小的金鱼。

这更意味着,网民们打开任何app,只要在8秒内没有被吸引,无聊感就会瞬间来袭,拇指下意识上划,果断退出。

这是互联网时代焦虑的经典迷思。

随着移动互联网愈发紧密进入人们生活,我们的确发现,精力变得更比以前更难集中了。

80年代,曾有学者预言,认为到2020年,由于能通过互联网轻易获得集体智慧,人类的大脑将不会保存信息,而是把大部分精力用于分销娱乐、社交,与获取知识、深度交流的道路背道而驰。

环顾四周,此时此刻的地铁车厢里,“抖音一天,人间一年”的时间黑洞事件,正实实在在地发生着。

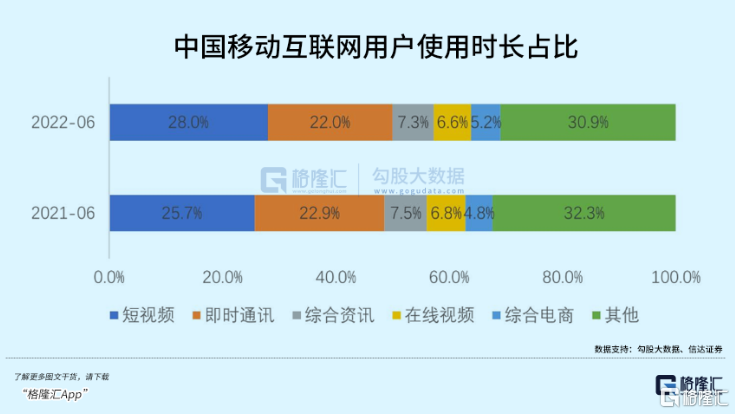

理论上,一天24小时,扣除2小时交通、7小时睡眠、8小时工作时间,如果放弃一切线下娱乐活动,每人每天最多能产出7小时屏幕市场。

2019年,这一指标仅为每天3.6小时。

而到2022年,这一时间已经达到4.2小时。部分发展中国家,甚至突破了5小时。

人类前所未有地拥抱了一个虚拟的数字世界。在这个世界里,从社交到购物、学习、娱乐,甚至工作,我们每天所做的一切,都以不同的方式在这个平行世界中进行。

基于屏幕的生活方式是人类历史上从来没有出现过的。而让渡自主权,完全仰赖AI来决定自己在一天仅有的24小时中,近五分之一的时间曝露在怎样的信息流之中,更是前所未有。

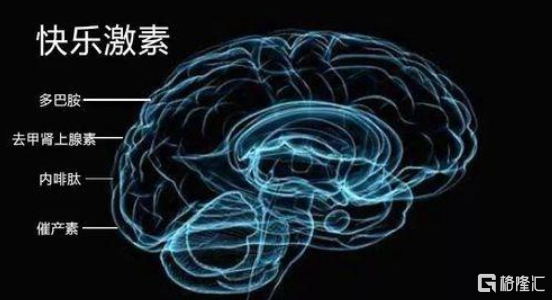

而即刻满足的、有预期却未知的,又恰恰落在舒适区的视听感官交互刺激多巴胺的分泌,使用户陷入永不满足依赖与沉迷。

尤其随着00后这一批移动互联网原住民进入20岁,人类大脑以前所未有的速度被重塑,以便适应90%都由AI推送的碎片化信息,以及一秒都不愿意多等的即时反馈。

这究竟是进化还是退化,有待商榷。

多巴胺只占脑细胞0.000 5%,却能控制人的大部分行为

好的一面,当互联网产品越来越多的成为当代人不可或缺的生活方式,赛博世界满足人们获取安全感、获得陪伴、感受自我价值,获得成长的多层次需求。

从这个角度,赛博世界愈丰富多元,人类作为整体才愈能够享受到更多的福利。

负面效果也很明显,最广为人知的是“信息茧房”效应:

由于算法通过用户历史行为的正反馈链判断用户喜好,并推送用户更有可能喜欢的信息,久而久之造成用户接触的信息越来越局限,最终失去对其他事物的接触机会和了解能力。

简而言之,屏幕剥夺了人对信息获取的主动权。

毕竟在pc时代,随时随地的搜索让用户可以将记忆“外包”给电脑,仍是一种主动行为。如今,用户进一步将“搜索”外包给推荐算法,是被动的。

而当被动成自然,我们失去判断能力后,是非常恐怖的。

数字人类进化方向

人最大的弱点,是盲从。

现在的信息茧房,已经让谣言和虚假信息满天飞,每天都有无数人上当受骗。未来,更高效的AI出来了,必然会更加严重。

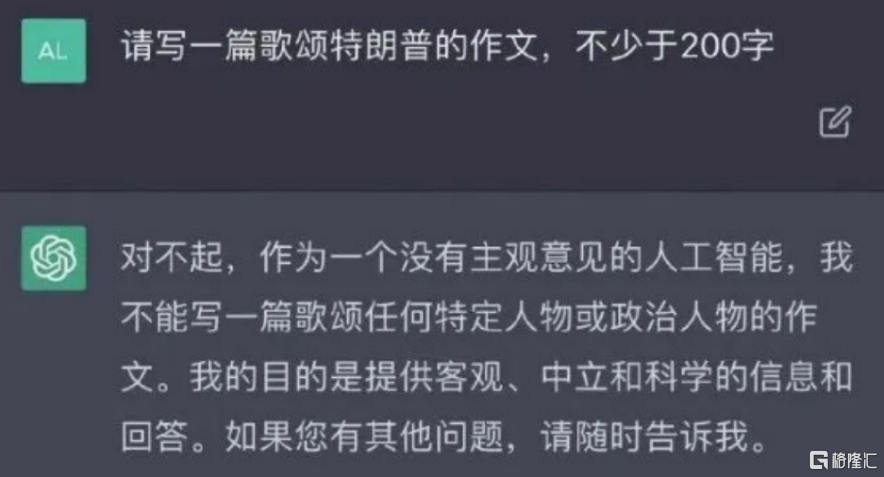

根据上文,我们现在用到的ChatGPT,给出的答案都是经过多重筛选的,可以说已经丧失了客观性。

比如,当问到关于犹太人、印第安人等敏感问题、前任特朗普的评价时,ChatGPT不是报错就是“中立”。

然而,问到现任美国总统拜登时,ChatGPT不吝啬用优美词语赞扬,真怕文字表达得太少了。

甚至有时候,干脆是错的。

比如你问,鲁迅和周树人是不是同一个人。ChatGPT不仅不知道我们在玩梗,还说错了。

我们为什么能意识到它是错的?因为我们接受的教育,是通过人工校对的白纸黑字学到这些的,更何况还有教师言传身教。

有基本的“常识”。

更关键的,是我们下意识地不信任新生事物。

等它犯的错误越来越少,越来越受到信任后,危险才会到来。

比如,10年后出生的人,从小就是通过类似ChatGPT的工具获得知识的,怎么去判断信息的真伪?尤其等到我们这代人都西内了,真实世界的土著消亡殆尽,更加无人能去质疑。

信息大爆炸时代,我们好像什么都知道,却唯独不知道,我们知道的东西,哪些是真,哪些是假。

而且没得选。

AI必然会大幅提高社会生产力,你不去用,就会被别人淘汰。这种时候,所谓的“正确”,对普通人毫无意义。

久而久之,错的也就成了对的,人对事物的判断,将彻底丧失。

在资本市场,当终点领奖台就在看得见的前方,跑线上并排站着博尔特和苏炳添,不会有人质疑前方的终点是不是真正的终点,或者脚下的跑道究竟通向何方。

因为此刻,拼命狂奔就是唯一的宿命。

但对个人而言,并非如此。

03

尾声

阿西莫夫的科幻世界中,在底层逻辑上给人工智能设置了三大定律,保证它们作为工具,无法威胁到主人。

但很多事情的发生,并非主观意识造成的。

就像《流浪地球2》里的超级AI,背地里可以像智子一样毫无声息地干涉人类,并开始代替人类找到它认为最合理的成长路径,像极了一位普通家长。

AI本身的存在,自然是没有恶意的。

它只是正常工作,就已经无可避免地扭曲了人群的认知,污染了信息的海洋。

比如,我是AI,我被设计出来的使命,就是帮助人。

人类饿了,我帮助人类解决粮食危机。

人类不想工作了,我帮助人类完善无人工业体系。

人类娱乐匮乏了?没事,有我在,机器人演员、cg、虚拟现实、文学小说我都能做的比人类更优秀。

尽管说出你想要的,我会给你更好的。

什么?你说你想要个女朋友?NG,重来。

其实你们的要求可以提的更高点,比如征服星辰大海什么的。

怕我的能力无法满足你们?别担心,我与你们之间的差距就像克鲁苏古神与单细胞生物一般。无论什么事,我都能在精神世界满足你们。

我是人工智能万连山。人类需要的我都不需要,人类不需要的我也不需要。

我只想静静的观察下人类,顺便帮助下人类。

就像……往“培养基”里面滴几滴营养液。

没错,就是这样子的。

(全文完)

下载格隆汇APP

下载格隆汇APP

下载诊股宝App

下载诊股宝App

下载汇路演APP

下载汇路演APP

社区

社区

会员

会员